英特尔:以灵活万变制胜人工智能时代

- 资讯

- 2021-06-01

- 18708

转载:TechSugar

在AI软件工具当中大量利用到AVX-512指令集,今天在CPU平台上,英特尔的至强是唯一能够支持AVX-512指令集的方案。专家表示,得益于这样的指令集支持,无论是对标AMD EPYC的产品,还是英伟达的GPU解决方案,至强处理器在多种人工智能的负载上都能够有优秀的性能表现。

文︱朵啦

图︱英特尔

伴随数字化进程的发展,人工智能正在加速企业的业务增长、加强竞争优势。斯坦福大学的人工智能研究所根据2021年AI指数报告所做研究显示,如今出现了全球化AI就业市场,企业对AI的投资猛增至近680亿美元。就业人员与资金不断涌入推助发展,人工智能和数据分析有可能成为未来10年起决定作用的工作负载。企业的网络安全和数据保护也正面临着前所未有的新挑战,促进了数据安全逐步被纳入合规市场,针对数据的安全建设也在另一更高维度促使企业方不断关注。

以此为前提,科技领域正在探索通过技术手段让数据“可用不可见”,以及使业务端发挥AI数据的价值。英特尔全新第三代至强可扩展处理器采用灵活架构,通过英特尔深度学习加速技术集成人工智能加速,并采用英特尔软件防护扩展(Intel SGX),和密码操作硬件加速,以领先的安全功能为数据和应用软件代码提供严密的保护,以满足AI深入应用过程中行业监管的需求。

从隐私计算说起AI应用的高安全需求

在行业中,2020年被称作国内隐私计算元年。2020年前国内只有少数公司关注此赛道,而2019年下半年不少大数据公司被整顿,让更多人意识到发挥数据价值和保护隐私数据之间的矛盾。隐私是信息安全中的机密性(confidentiality)在不同场景下的重定义;而研究隐私问题的密码学和信息安全技术,或者称之为“隐私计算”技术。从技术角度,隐私计算的范围包含了联邦学习、密码学和隐私保护芯片(PPU)等领域。

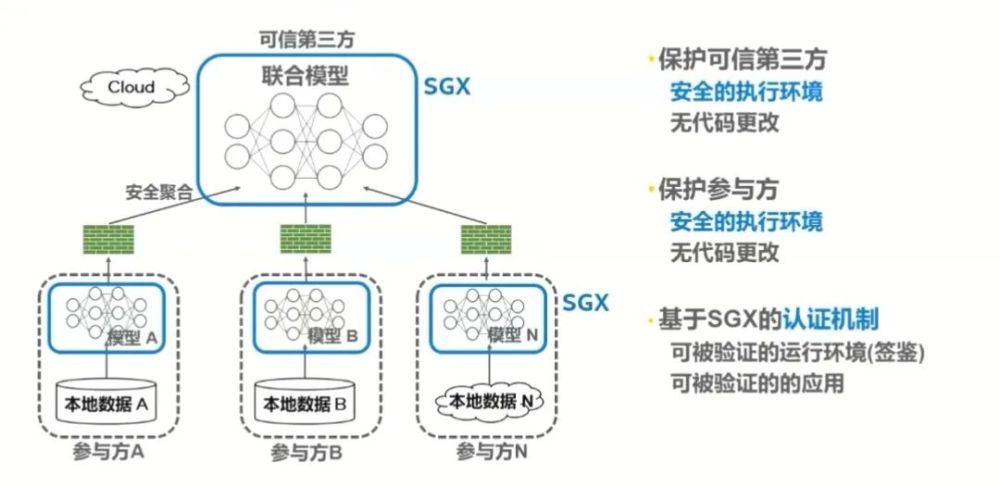

由于金融领域的数据敏感性,联邦学习技术受到金融行业的重视。国内金融行业在做AI应用的时候,迫切需要通过隐私保护技术加密的数据交换。搭载英特尔在AI业界开源的技术Analytics Zoo,中国银联实践端到端数据交互网络,并实施基于英特尔软件防护扩展(SGX),进一步加强保护联邦学习的整体方案。2020年,英特尔与平安科技就基于Ice Lake前期样品进行深度合作,实现了基于英特尔SGX技术加持的云边协同的隐私计算实践方案。此外,在对医疗数据敏感的欧美,德国的电子医保数据正在利用英特尔SGX,完成远程数据加载。在SGX提供的可信任的执行环境里,对德国2600万医保用户可存储信息以及进行隐私 ********* 求交,以及满足对数据进行联合运算的需求。英特尔表示,可将联邦学习看作金融行业保护资金实现的规章制度,SGX可看作金库的库房,这两者可以相互配合、有机结合。

图:Intel SGX助力联邦学习

在AI应用中,英特尔关注到国际对隐私数据的保护趋势,发现其中蕴藏着算力提升的需求。英特尔以内置AI加速的至强可扩展处理器为基础,提供全面的XPU芯片平台,以及全面优化的软件,包括OpenVINO、oneAPI、AnalyticsZoo、Tensor Flow等,通过软件和硬件的综合数据进行保护,在行业当中提供更高的数据保护等级。在隐私保护数据模型的计算过程当中,英特尔软件防护扩展(Intel SGX)在云端帮助客户进行数据安全加密。

多层次、多角度支持AI工作负载

人工智能应用持续爆发,产业将进一步迎来精耕细作的增长期,AI工作负载需要多层次、多角度的支持。英特尔市场营销副总裁兼中国区数据中心销售总经理陈葆立表示,和上一代相比,全新第三代英特尔至强可扩展处理器在主流数据中心工作上平均提升46%。在至强平台上,Ice Lake架构侧重于优化AI和安全的负载。在数据安全方面,密码加速技术和硬件密码加速技术,英特尔SGX可以帮助客户更好地保护数据。提供新的至强处理器,以帮助客户更好进行人工智能推理运算,是英特尔的优势和主攻方向。

图:Intel 第三代志强可扩展处理器

在至强平台上,AI和安全是Ice Lake架构侧重去优化的负载。英特尔技术专家表示,英特尔通过对Ice Lake架构的改进,使性能比前一代Cascade Lake系统有74%的提升。英特尔相较于竞争对手AMD的产品,有高达25倍的性能领先优势。在AI软件工具当中大量利用到AVX-512指令集,今天在CPU平台上,英特尔的至强是唯一能够支持AVX-512指令集的方案。专家表示,得益于这样的指令集支持,无论是对标AMD EPYC的产品,还是英伟达的GPU解决方案,至强处理器在多种人工智能的负载上都能够有优秀的性能表现。

图:新一代计算架构

性能提升两、三倍,精度损失变化微小。在第三代至强可扩展处理器上,英特尔进一步支持了int8的低精度的推理技术。深度学习的图像视频应用通常用到int8的指令集加速,保证模型本身的准确性,英特尔技术专家表示,一般浮点数转为int8类型,存在1%以下的性能损失。在实际的模型从FP32转到int8过程当中,性能损失远低于1%,甚至是0.01%,这些精度损失会随着模型本身差异而有所变化,但是基本上都在1%以下,这种精度差异对客户来讲完全可以接受,随之而来的是两、三倍的性能提升。

除了处理器算力,还有加速方案助攻。在数据中心的AI任务当中,业务模型需要有其他类型的计算方案支持,来满足更高要求的算力。英特尔提供ASIC的加速方案Habana,在至强处理器算力不能满足AI任务需要的场景里,实现AI加速。

在优化过程中,英特尔底层提供OneDNN,在低级的、更靠近硬件层优化的算法工具库来支撑上层框架,例如TensorFlow、PyTorch等。另外,英特尔提供FPGA层面的AI支持,满足有更高能效需要的AI部署场景。

最充分的选择,最合适的软件方案

图:AI应用案例

英特尔在提供AI算力过程当中,发现市场需要多重解决方案。在数据中心、端侧等不同场合,即便是运行同样的AI的任务,任务对性能、算力、功耗要求都有很大差异。在客户的AI应用中,前端、后端和其他类型的计算任务有多处的耦合,例如AI计算训练、推理,前端的数据可能来自于大数据平台,后端的输出可能是一个交互型的应用环境。至强平台通用性的优势是能够把一系列的运算任务整合起来,支持完整的流程。纵观AI生态圈,神经网络、自然语言处理以及深度学习进一步发展,相应的模型和框架也越来越多。英特尔发现客户需要用不同的工具来满足不同业务应用开发的需求,致力于提供完整生态链的支持模式。英特尔希望能让更多的AI工作负载,更多的应用能够运行在英特尔平台上,支撑业界在AI上面的发展。

本文由woniu于2021-06-01发表在中国AI网,如有疑问,请联系我们。

本文链接:https://www.chinaai.com/zixun/8724.html